To wielostronicowy widok tej sekcji do wydrukowania. Kliknij aby wydrukować.

Dokumentacja

- 1: Kubernetes — Dokumentacja

- 2: Od czego zacząć

- 3: Pojęcia

- 3.1: Przegląd

- 3.1.1: Składniki Kubernetesa

- 3.1.2: Objekty w Kubernetesie

- 3.1.2.1: Nazwy i identyfikatory objektów

- 3.1.2.2: Etykiety i selektory

- 3.1.2.3: Przestrzenie nazw (ang. Namespaces)

- 3.1.2.4: Adnotatcje

- 3.1.2.5: Selektory pól

- 3.1.3: API Kubernetesa

- 3.2: Architektura klastra

- 3.3: Kontenery

- 3.4: Workload

- 3.4.1: Pod

- 3.4.2: Zarządzanie Workloadem

- 3.5: Usługi, równoważenie obciążenia i sieci w Kubernetesie

- 3.6: Przechowywanie danych

- 3.7: Konfiguracja

- 3.8: Bezpieczeństwo

- 3.9: Polityki

- 3.10: Harmonogramowanie, pierszeństwo i eksmisja

- 3.11: Administracja klastrem

- 3.12: Windows w Kubernetesie

- 3.13: Rozszerzanie Kubernetesa

- 4: Zadania

- 5: Samouczki

- 5.1: Hello Minikube

- 5.2: Naucz się podstaw Kubernetesa

- 5.2.1: Tworzenie klastra

- 5.2.2: Instalowanie aplikacji

- 5.2.3: Poznawanie aplikacji

- 5.2.3.1: Pody i Węzły

- 5.2.4: Udostępnianie aplikacji

- 5.2.5: Skalowanie aplikacji

- 5.2.6: Aktualizowanie aplikacji

- 5.2.6.1: Aktualizacje Rolling Update

- 6: Materiały źródłowe

- 6.1: Słownik

- 7: Współtwórz dokumentację K8s

- 7.1: Współtworzenie dokumentacji Kubernetes

- 7.2: Zgłaszanie propozycji poprawy treści

- 7.3: Współtworzenie nowych treści

- 7.4: Przeglądanie zmian

- 7.5: Tłumaczenie i adaptacja językowa dokumentacji Kubernetes

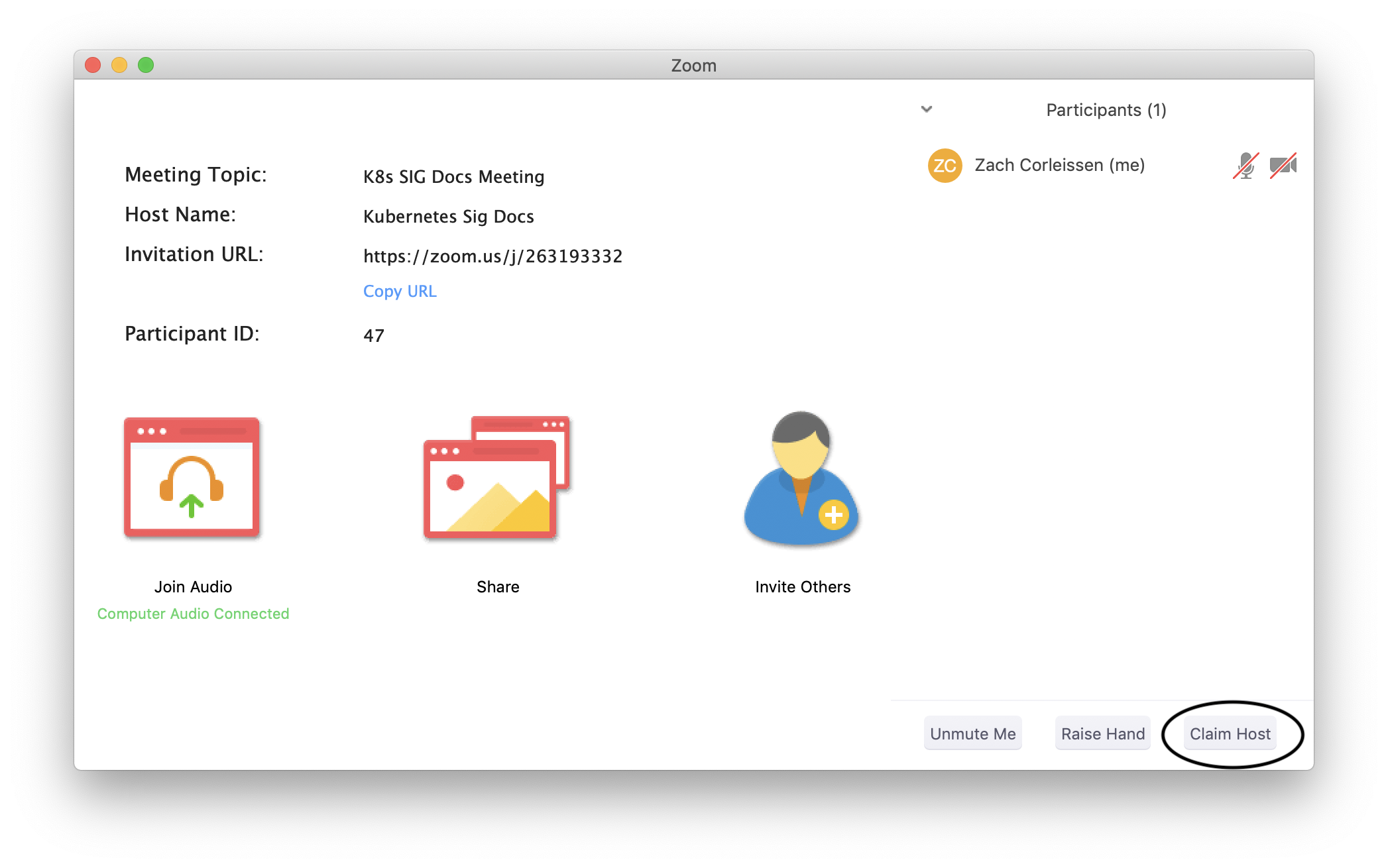

- 7.6: Współpraca z SIG Docs

- 7.7: Aktualizacja materiałów źródłowych

- 7.7.1: Wkład w kod źródłowy Kubernetesa

- 7.7.2: Generowanie materiałów źródłowych dla polecenia kubectl

- 7.7.3: Generowanie materiałów źródłowych dla metryk

- 7.7.4: Generowanie materiałów źródłowych dla komponentów i narzedzi Kubernetesa

- 7.7.5:

- 7.8: Styl dokumentacji

- 7.8.1: Typy treści

- 7.9: Zaawansowana współpraca

- 7.10: Przeglądanie statystyki strony

- 7.11: Tłumaczenie dokumentacji na język polski

1 - Kubernetes — Dokumentacja

1.1 - Dostępne wersje dokumentacji

Ten serwis zawiera dokumentację do bieżącej i czterech poprzednich wersji Kubernetesa.

Dostępność dokumentacji obejmującej konkretną wersję Kubernetesa nie oznacza automatycznie, że dana wersja Kubernetesa jest ciągle aktywnie wspierana. Zajrzyj do dokumentu Support period, aby dowiedzieć się, do kiedy objęte wsparciem są poszczególne wersje Kubernetesa.

2 - Od czego zacząć

Ten rozdział poświęcony jest różnym metodom konfiguracji i uruchomienia Kubernetesa. Instalując Kubernetesa, przy wyborze platformy kieruj się: łatwością w utrzymaniu, spełnianymi wymogami bezpieczeństwa, poziomem sterowania, dostępnością zasobów oraz doświadczeniem wymaganym do zarządzania klastrem.

Możesz pobrać Kubernetesa, aby zainstalować klaster na lokalnym komputerze, w chmurze czy w prywatnym centrum obliczeniowym.

Niektóre komponenty Kubernetesa, na przykład `kube-apiserver czy kube-proxy mogą być uruchamiane jako kontenery wewnątrz samego klastra.

Zalecamy uruchamianie komponentów Kubernetesa jako kontenery zawsze, kiedy jest to możliwe i na zarządzanie nimi przez samego Kubernetesa. Do tej kategorii nie należą komponenty odpowiedzialne za uruchamianie kontenerów, w szczególności - kubelet.

Jeśli nie chcesz zarządzać klastrem Kubernetesa samodzielnie, możesz wybrać serwis zarządzany przez zewnętrznego dostawcę, wybierając na przykład spośród certyfikowanych platform. Dostępne są także inne standardowe i specjalizowane rozwiązania dla różnych środowisk chmurowych bądź bazujące bezpośrednio na sprzęcie fizycznym.

Środowisko do nauki

Do nauki Kubernetesa wykorzystaj narzędzia wspierane przez społeczność Kubernetesa lub inne narzędzia dostępne w ekosystemie, aby uruchomić klaster Kubernetesa na swoim komputerze lokalnym. Zapoznaj się ze stroną Środowisko edukacyjne.

Środowisko produkcyjne

Wybierając rozwiązanie dla środowiska produkcyjnego musisz zdecydować, którymi poziomami zarządzania klastrem (abstrakcjami) chcesz zajmować się sam, a które będą realizowane po stronie zewnętrznego operatora.

Do instalacji klastra Kubernetesa zarządzanego samodzielnie oficjalnym narzędziem jest kubeadm.

Co dalej?

- Pobierz Kubernetesa

- Pobierz i zainstaluj narzędzia, w tym

kubectl - Wybierz środowisko uruchomieniowe dla kontenerów w nowym klastrze

- Naucz się najlepszych praktyk przy konfigurowaniu klastra

Kubernetes zaprojektowano w ten sposób, że warstwa sterowania wymaga do działania systemu Linux. W ramach klastra aplikacje mogą być uruchamiane na systemie Linux i innych, w tym Windows.

- Naucz się, jak zbudować klaster z węzłami Windows

3 - Pojęcia

Rozdział dotyczący pojęć ma za zadanie pomóc w zrozumieniu poszczególnych składowych systemu oraz obiektów abstrakcyjnych, których Kubernetes używa do reprezentacji klastra, a także posłużyć do lepszego poznania działania całego systemu.

3.1 - Przegląd

Na tej stronie znajdziesz ogólne informacje o Kubernetesie.

Nazwa Kubernetes pochodzi z języka greckiego i oznacza sternika albo pilota. Skrót K8s powstał poprzez zastąpienie ośmiu liter pomiędzy "K" i "s". Google otworzyło projekt Kubernetes publicznie w 2014. Kubernetes korzysta z piętnastoletniego doświadczenia Google w uruchamianiu wielkoskalowych serwisów i łączy je z najlepszymi pomysłami i praktykami wypracowanymi przez społeczność.

Do czego potrzebujesz Kubernetesa i jakie są jego możliwości

Kontenery są dobrą metodą na opakowywanie i uruchamianie aplikacji. W środowisku produkcyjnym musisz zarządzać kontenerami, w których działają aplikacje i pilnować, aby nie było żadnych przerw w ich dostępności. Przykładowo, kiedy jeden z kontenerów przestaje działać, musi zostać wymieniony. Nie byłoby prościej, aby takimi działaniami zajmował się jakiś system?

I tu właśnie przychodzi z pomocą Kubernetes! Kubernetes zapewnia środowisko do uruchamiania systemów rozproszonych o wysokiej niezawodności. Kubernetes obsługuje skalowanie aplikacji, przełączanie w sytuacjach awaryjnych, różne scenariusze wdrożeń itp. Przykładowo, Kubernetes w łatwy sposób może zarządzać wdrożeniem nowej wersji oprogramowania zgodnie z metodyką canary deployments.

Kubernetes zapewnia:

- Detekcję nowych serwisów i balansowanie ruchu Kubernetes może udostępnić kontener używając nazwy DNS lub swojego własnego adresu IP. Jeśli ruch przychodzący do kontenera jest duży, Kubernetes może balansować obciążenie i przekierować ruch sieciowy, aby zapewnić stabilność całej instalacji.

- Zarządzanie obsługą składowania danych Kubernetes umożliwia automatyczne montowanie systemów składowania danych dowolnego typu - lokalnych, od dostawców chmurowych i innych.

- Automatyczne wdrożenia i wycofywanie zmian Możesz opisać oczekiwany stan instalacji za pomocą Kubernetesa, który zajmie się doprowadzeniem w sposób kontrolowany stanu faktycznego do stanu oczekiwanego. Przykładowo, przy pomocy Kubernetesa możesz zautomatyzować proces tworzenia nowych kontenerów na potrzeby swojego wdrożenia, usuwania istniejących i przejęcia zasobów przez nowe kontenery.

- Automatyczne zarządzanie dostępnymi zasobami Twoim zadaniem jest dostarczenie klastra maszyn, które Kubernetes może wykorzystać do uruchamiania zadań w kontenerach. Określasz zapotrzebowanie na moc procesora i pamięć RAM dla każdego z kontenerów. Kubernetes rozmieszcza kontenery na maszynach w taki sposób, aby jak najlepiej wykorzystać dostarczone zasoby.

- Samoczynne naprawianie Kubernetes restartuje kontenery, które przestały działać, wymienia je na nowe, wymusza wyłączenie kontenerów, które nie odpowiadają na określone zapytania o stan i nie rozgłasza powiadomień o ich dostępności tak długo, dopóki nie są gotowe do działania.

- Zarządzanie informacjami poufnymi i konfiguracją Kubernetes pozwala składować i zarządzać informacjami poufnymi, takimi jak hasła, tokeny OAuth czy klucze SSH. Informacje poufne i zawierające konfigurację aplikacji mogą być dostarczane i zmieniane bez konieczności ponownego budowania obrazu kontenerów i bez ujawniania poufnych danych w ogólnej konfiguracji oprogramowania.

- Wykonywanie wsadowe Oprócz usług Kubernetes może zarządzać zadaniami wsadowymi i obciążeniami CI, automatycznie wymieniając kontenery, które ulegną awarii.

- Skalowanie poziome Skaluj swoją aplikację w górę i w dół za pomocą prostego polecenia, poprzez interfejs użytkownika lub automatycznie na podstawie zużycia CPU.

- Podwójny stos IPv4/IPv6 Przydzielanie adresów IPv4 i IPv6 do podów i usług

- Możliwość rozbudowy Dodawaj funkcje do swojego klastra Kubernetesa bez konieczności zmiany kodu źródłowego w głównym repozytorium.

Czym Kubernetes nie jest

Kubernetes nie jest tradycyjnym, zawierającym wszystko systemem PaaS (Platform as a Service). Ponieważ Kubernetes działa w warstwie kontenerów, a nie sprzętu, posiada różne funkcjonalności ogólnego zastosowania, wspólne dla innych rozwiązań PaaS, takie jak: instalacje (deployments), skalowanie i balansowanie ruchu, umożliwiając użytkownikom integrację rozwiązań służących do logowania, monitoringu i ostrzegania. Co ważne, Kubernetes nie jest monolitem i domyślnie dostępne rozwiązania są opcjonalne i działają jako wtyczki. Kubernetes dostarcza elementy, z których może być zbudowana platforma deweloperska, ale pozostawia użytkownikowi wybór i elastyczność tam, gdzie jest to ważne.

Kubernetes:

- Nie ogranicza typów aplikacji, które są obsługiwane. Celem Kubernetesa jest możliwość obsługi bardzo różnorodnego typu zadań, włączając w to aplikacje bezstanowe (stateless), aplikacje ze stanem (stateful) i ogólne przetwarzanie danych. Jeśli jakaś aplikacja może działać w kontenerze, będzie doskonale sobie radzić w środowisku Kubernetesa.

- Nie oferuje wdrażania aplikacji wprost z kodu źródłowego i nie buduje aplikacji. Procesy Continuous Integration, Delivery, and Deployment (CI/CD) są zależne od kultury pracy organizacji, jej preferencji oraz wymagań technicznych.

- Nie dostarcza serwisów z warstwy aplikacyjnej, takich jak warstwy pośrednie middleware (np. broker wiadomości), środowiska analizy danych (np. Spark), bazy danych (np. MySQL), cache ani klastrowych systemów składowania danych (np. Ceph) jako usług wbudowanych. Te składniki mogą być uruchamiane na klastrze Kubernetes i udostępniane innym aplikacjom przez przenośne rozwiązania, takie jak Open Service Broker.

- Nie wymusza użycia konkretnych systemów zbierania logów, monitorowania ani ostrzegania. Niektóre z tych rozwiązań są udostępnione jako przykłady. Dostępne są też mechanizmy do gromadzenia i eksportowania różnych metryk.

- Nie dostarcza, ani nie wymusza języka/systemu używanego do konfiguracji (np. Jsonnet). Udostępnia API typu deklaratywnego, z którego można korzystać za pomocą różnych metod wykorzystujących deklaratywne specyfikacje.

- Nie zapewnia, ani nie wykorzystuje żadnego ogólnego systemu do zarządzania konfiguracją, utrzymaniem i samo-naprawianiem maszyn.

- Co więcej, nie jest zwykłym systemem planowania (orchestration). W rzeczywistości, eliminuje konieczność orkiestracji. Zgodnie z definicją techniczną, orkiestracja to wykonywanie określonego ciągu zadań: najpierw A, potem B i następnie C. Dla kontrastu, Kubernetes składa się z wielu niezależnych, możliwych do złożenia procesów sterujących, których zadaniem jest doprowadzenie stanu faktycznego do stanu oczekiwanego. Nie ma znaczenia, w jaki sposób przechodzi się od A do C. Nie ma konieczności scentralizowanego zarządzania. Dzięki temu otrzymujemy system, który jest potężniejszy, bardziej odporny i niezawodny i dający więcej możliwości rozbudowy.

Trochę historii

Aby zrozumieć, dlaczego Kubernetes stał się taki przydatny, cofnijmy sie trochę w czasie.

Era wdrożeń tradycyjnych:

Na początku aplikacje uruchamiane były na fizycznych serwerach. Nie było możliwości separowania zasobów poszczególnych aplikacji, co prowadziło do problemów z alokacją zasobów. Przykładowo, kiedy wiele aplikacji jest uruchomionych na jednym fizycznym serwerze, część tych aplikacji może zużyć większość dostępnych zasobów, powodując spowolnienie działania innych. Rozwiązaniem tego problemu mogło być uruchamianie każdej aplikacji na osobnej maszynie. Niestety, takie podejście ograniczało skalowanie, ponieważ większość zasobów nie była w pełni wykorzystywana, a utrzymanie wielu fizycznych maszyn było kosztowne.

Era wdrożeń w środowiskach wirtualnych:

Jako rozwiązanie zaproponowano wirtualizację, która umożliwia uruchamianie wielu maszyn wirtualnych (VM) na jednym procesorze fizycznego serwera. Wirtualizacja pozwala izolować aplikacje pomiędzy maszynami wirtualnymi, zwiększając w ten sposób bezpieczeństwo, jako że informacje związane z jedną aplikacją nie są w łatwy sposób dostępne dla pozostałych.

Wirtualizacja pozwala lepiej wykorzystywać zasoby fizycznego serwera i lepiej skalować, ponieważ aplikacje mogą być łatwo dodawane oraz aktualizowane, pozwala ograniczyć koszty sprzętu oraz ma wiele innych zalet. Za pomocą wirtualizacji można udostępnić wybrane zasoby fizyczne jako klaster maszyn wirtualnych "wielokrotnego użytku".

Każda maszyna wirtualna jest pełną maszyną zawierającą własny system operacyjny pracujący na zwirtualizowanej warstwie sprzętowej.

Era wdrożeń w kontenerach:

Kontenery działają w sposób zbliżony do maszyn wirtualnych, ale mają mniejszy stopnień wzajemnej izolacji, współdzieląc ten sam system operacyjny. Kontenery określane są mianem "lekkich". Podobnie, jak maszyna wirtualna, kontener posiada własny system plików, udział w zasobach procesora, pamięć, przestrzeń procesów itd. Ponieważ kontenery są definiowane rozłącznie od leżących poniżej warstw infrastruktury, mogą być łatwiej przenoszone pomiędzy chmurami i różnymi dystrybucjami systemu operacyjnego.

Kontenery zyskały popularność ze względu na swoje zalety, takie jak:

- Szybkość i elastyczność w tworzeniu i instalacji aplikacji: obraz kontenera buduje się łatwiej niż obraz VM.

- Ułatwienie ciągłego rozwoju, integracji oraz wdrażania aplikacji ( Continuous development, integration, and deployment): obrazy kontenerów mogą być budowane w sposób wiarygodny i częsty. W razie potrzeby, przywrócenie poprzedniej wersji aplikacji jest stosunkowo łatwie (ponieważ obrazy są niezmienne).

- Rozdzielenie zadań Dev i Ops: obrazy kontenerów powstają w fazie build/release, a nie w trakcie procesu instalacji, oddzielając w ten sposób aplikacje od infrastruktury.

- Obserwowalność obejmuje nie tylko informacje i metryki z poziomu systemu operacyjnego, ale także poprawność działania samej aplikacji i inne sygnały.

- Spójność środowiska na etapach rozwoju oprogramowania, testowania i działania w trybie produkcyjnym: działa w ten sam sposób na laptopie i w chmurze.

- Możliwość przenoszenia pomiędzy systemami operacyjnymi i platformami chmurowymi: Ubuntu, RHEL, CoreOS, prywatnymi centrami danych, największymi dostawcami usług chmurowych czy gdziekolwiek indziej.

- Zarządzanie, które w centrum uwagi ma aplikacje: Poziom abstrakcji przeniesiony jest z warstwy systemu operacyjnego działającego na maszynie wirtualnej na poziom działania aplikacji, która działa na systemie operacyjnym używając zasobów logicznych.

- Luźno powiązane, rozproszone i elastyczne "swobodne" mikro serwisy: Aplikacje podzielone są na mniejsze, niezależne komponenty, które mogą być dynamicznie uruchamiane i zarządzane - nie jest to monolityczny system działający na jednej, dużej maszynie dedykowanej na wyłączność.

- Izolacja zasobów: wydajność aplikacji możliwa do przewidzenia

- Wykorzystanie zasobów: wysoka wydajność i upakowanie.

Co dalej?

- Poczytaj o komponentach Kubernetesa

- Poczytaj o API Kubernetesa

- Poczytaj o architekturze klastra

- Jesteś gotowy zacząć pracę?

3.1.1 - Składniki Kubernetesa

Ta strona zawiera wysokopoziomy przegląd niezbędnych komponentów, które tworzą klaster Kubernetesa.

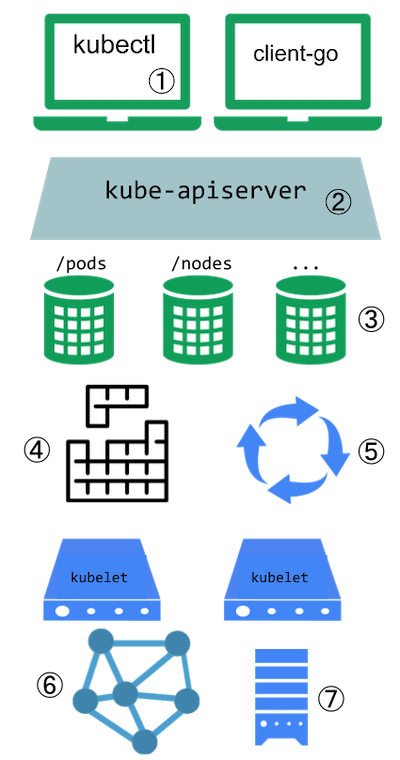

Komponenty klastra Kubernetesa

Składniki Kubernetesa

Klaster Kubernetesa składa się z warstwy sterowania oraz jednego lub więcej węzłów roboczych. Oto krótki przegląd głównych komponentów:

Części składowe warstwy sterowania

Zarządzanie ogólnym stanem klastra:

- kube-apiserver

- Podstawowy komponent udostępniający interfejs API Kubernetesa przez HTTP.

- etcd

- Stabilna i wysoko dostępna baza danych typu klucz-wartość, wykorzystywana do przechowywania stanu całego klastra Kubernetesa.

- kube-scheduler

- Wyszukuje Pody, które nie zostały jeszcze przypisane do węzła, i przydziela każdy Pod do odpowiedniego węzła.

- kube-controller-manager

- Uruchamia kontrolery realizujące logikę działania API Kubernetesa.

- cloud-controller-manager (opcjonalne)

- Zapewnia integrację klastra Kubernetesa z infrastrukturą dostarczaną przez zewnętrznych dostawców chmurowych.

Składniki węzłów

Działa na każdym węźle klastra, odpowiada za utrzymanie aktywnych podów oraz zapewnienie środowiska uruchomieniowego Kubernetesa:

- kubelet

- Odpowiada za nadzorowanie, czy pody oraz ich kontenery są uruchomione i działają zgodnie z oczekiwaniami.

- kube-proxy (opcjonalne)

- Utrzymuje reguły sieciowe na węzłach w celu obsługi komunikacji z usługami (ang. Service).

- Środowisko uruchomieniowe kontenerów

- Oprogramowanie odpowiedzialne za uruchamianie kontenerów. Przeczytaj Środowiska uruchomieniowe kontenerów, aby dowiedzieć się więcej.

Klaster może wymagać dodatkowego oprogramowania na każdym węźle; możesz na przykład uruchomić systemd na węzłach z systemem Linux do monitorowania i zarządzania lokalnymi usługami.

Dodatki (Addons)

Dodatki rozszerzają funkcjonalność Kubernetesa. Oto kilka ważnych przykładów:

- DNS

- Umożliwia rozpoznawanie nazw DNS dla usług i komponentów działających w całym klastrze.

- Web UI (Dashboard)

- Umożliwia zarządzanie klastrem Kubernetesa poprzez webowy interfejs.

- Monitorowanie zasobów kontenera

- Służy do monitorowania zasobów kontenerów poprzez gromadzenie i zapisywanie danych o ich wydajności.

- Logowanie na poziomie klastra

- Umożliwia zbieranie i przechowywanie logów z kontenerów w centralnym systemie logowania dostępnym na poziomie całego klastra.

Elastyczność architektury

Dzięki elastycznej architekturze Kubernetesa można dostosować sposób wdrażania i zarządzania poszczególnymi komponentami do konkretnych wymagań - od prostych klastrów deweloperskich po złożone systemy produkcyjne na dużą skalę.

Szczegółowe informacje o każdym komponencie oraz różnych sposobach konfiguracji architektury klastra znajdziesz na stronie Architektura klastra.

3.1.2 - Objekty w Kubernetesie

Ta strona wyjaśnia, jak obiekty Kubernetesa są reprezentowane w

API Kubernetesa oraz jak można je wyrazić w formacie .yaml.

Czym są obiekty Kubernetesa

Obiekty Kubernetesa to trwałe byty w systemie Kubernetes. Kubernetes wykorzystuje te byty do reprezentowania stanu klastra. Konkretne zastosowania to m.in.:

- Jakie aplikacje kontenerowe są uruchomione (i na których węzłach)

- Zasoby dostępne dla tych aplikacji

- Polityki dotyczące zachowania tych aplikacji, takie jak polityki restartu, aktualizacje i tolerancja na błędy

Obiekt Kubernetesa to "zapis zamiaru" - gdy go utworzysz, Kubernetes będzie stale pilnować, aby taki obiekt faktycznie istniał. Tworząc obiekt, efektywnie informujesz Kubernetesa, jak ma wyglądać workload klastra; to jest pożądany stan twojego klastra.

Aby pracować z obiektami Kubernetesa-czy to w celu ich tworzenia, modyfikacji, czy

usuwania—musisz użyć API Kubernetesa. Na przykład, kiedy używasz

interfejsu wiersza poleceń kubectl, CLI wykonuje dla ciebie niezbędne wywołania

do API Kubernetesa. Możesz także używać API Kubernetesa bezpośrednio w swoich własnych

programach, korzystając z jednej z bibliotek klienckich.

Specyfikacja i status obiektu

Prawie każdy obiekt Kubernetesa zawiera dwa zagnieżdżone pola obiektowe,

które zarządzają konfiguracją obiektu: obiekt

spec i obiekt status. W przypadku obiektów, które mają

spec, musisz go ustawić podczas tworzenia obiektu,

dostarczając opis cech, jakie chcesz, aby zasób posiadał: jego pożądany stan.

Status opisuje aktualny stan obiektu, dostarczany i

aktualizowany przez system Kubernetes i jego komponenty. Kubernetes

warstwa sterowania stale

i aktywnie zarządza rzeczywistym stanem

każdego obiektu, aby dopasować go do pożądanego stanu, który dostarczyłeś.

Na przykład: w Kubernetesie, Deployment jest obiektem, który

może reprezentować aplikację działającą na twoim klastrze.

Kiedy tworzysz Deployment, możesz ustawić spec Deploymentu, aby

określić, że chcesz, aby uruchomione były trzy repliki

aplikacji. System Kubernetes odczytuje spec Deploymentu i uruchamia

trzy instancje twojej pożądanej aplikacji—aktualizując status,

aby dopasować go do twojego spec. Jeśli któraś z instancji

ulegnie awarii (czyli zmieni się status), Kubernetes zareaguje na różnicę

między spec a status - w tym przypadku, uruchamiając nową instancję.

Aby uzyskać więcej informacji na temat specyfikacji obiektu, statusu i metadanych, zobacz Kubernetes API Conventions.

Opis obiektu w Kubernetesie

Kiedy tworzysz obiekt w Kubernetesie, musisz dostarczyć specyfikację obiektu,

która opisuje jego pożądany stan, a także podstawowe informacje o obiekcie (takie

jak nazwa). Gdy używasz API Kubernetesa do tworzenia obiektu (bezpośrednio lub za

pośrednictwem kubectl), żądanie API musi zawierać te informacje w formacie JSON

w treści żądania. Najczęściej dostarczasz informacje do kubectl w pliku znanym

jako manifest. Zgodnie z konwencją, manifesty są w formacie YAML (możesz

również użyć formatu JSON). Narzędzia takie jak kubectl konwertują informacje z

manifestu na JSON lub inny obsługiwany format serializacji podczas wysyłania żądania API przez HTTP.

Oto przykład manifestu pokazujący wymagane pola oraz specyfikację obiektu dla Deployment w Kubernetesie:

apiVersion: apps/v1

kind: Deployment

metadata:

name: nginx-deployment

spec:

selector:

matchLabels:

app: nginx

replicas: 2 # tells deployment to run 2 pods matching the template

template:

metadata:

labels:

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Jednym ze sposobów utworzenia Deploymentu przy użyciu pliku manifestu, takiego jak powyżej,

jest użycie polecenia kubectl apply

w interfejsie wiersza poleceń kubectl, przekazując plik .yaml jako argument. Oto przykład:

kubectl apply -f https://k8s.io/examples/application/deployment.yaml

Wynik jest podobny do tego:

deployment.apps/nginx-deployment created

Wymagane pola

W manifeście (pliku YAML lub JSON) dla obiektu Kubernetesa, który chcesz utworzyć, musisz ustawić wartości dla następujących pól:

apiVersion- Której wersji API Kubernetesa używasz do utworzenia tego obiektukind- Jakiego rodzaju obiekt chcesz utworzyćmetadata- Dane pomagające jednoznacznie zidentyfikować obiekt, w tym łańcuch znakówname,UIDoraz opcjonalnienamespace.spec- Jaki stan jest pożądany dla obiektu

Dokładny format obiektu spec jest inny dla każdego obiektu Kubernetesa i zawiera zagnieżdżone

pola specyficzne dla tego obiektu. Kubernetes API Reference

może pomóc ci znaleźć format spec dla wszystkich obiektów, które możesz utworzyć przy użyciu Kubernetesa.

Na przykład, zobacz pole spec

w odniesieniu do API Poda. Dla

każdego Poda, pole .spec określa pod i jego pożądany stan (taki jak nazwa obrazu

kontenera dla każdego kontenera w ramach tego poda). Innym

przykładem specyfikacji obiektu jest pole spec

dla

API StatefulSet. Dla StatefulSet, pole .spec określa StatefulSet i

jego pożądany stan. W ramach .spec dla StatefulSet znajduje się

szablon dla obiektów Pod. Ten

szablon opisuje Pody, które kontroler StatefulSet utworzy w celu spełnienia

specyfikacji StatefulSet. Różne rodzaje obiektów mogą

również mieć różne .status; ponownie, strony referencyjne API

szczegółowo opisują strukturę tego pola .status i jego zawartość dla każdego rodzaju obiektu.

Zobacz Najlepsze Praktyki Konfiguracji aby uzyskać dodatkowe informacje na temat pisania plików konfiguracyjnych YAML.

Walidacja pól po stronie serwera

Począwszy od wersji Kubernetesa v1.25, serwer API oferuje

walidację pól po

stronie serwera, która wykrywa nierozpoznane lub zduplikowane pola w

obiekcie. Zapewnia ona całą funkcjonalność kubectl --validate po stronie serwera.

Narzędzie kubectl używa flagi --validate do ustawiania poziomu walidacji pól. Akceptuje

wartości ignore, warn oraz strict, a także akceptuje wartości true (równoważne strict) i

false (równoważne ignore). Domyślne ustawienie walidacji dla kubectl to --validate=true.

Strict : Ścisła walidacja pól,

błędy w przypadku niepowodzenia walidacji

Warn : Walidacja pola jest przeprowadzana, ale błędy są

zgłaszane jako ostrzeżenia zamiast powodować niepowodzenie żądania.

Ignore : Nie jest wykonywana

żadna walidacja pola po stronie serwera

Kiedy kubectl nie może połączyć się z serwerem API, który obsługuje walidację pól,

przełączy się na użycie walidacji po stronie klienta. Kubernetes 1.27 i nowsze wersje zawsze

oferują walidację pól; starsze wydania Kubernetesa mogą tego nie robić. Jeśli twój

klaster jest starszy niż v1.27, sprawdź dokumentację dla swojej wersji Kubernetesa.

Co dalej?

Jeśli dopiero zaczynasz swoją przygodę z Kubernetesem, przeczytaj więcej na temat:

- Pody, które są najważniejszymi podstawowymi obiektami Kubernetesa.

- Obiekty Deployment.

- Kontrolery w Kubernetesie.

- kubectl i kubectl commands.

Zarządzanie obiektami Kubernetesa

wyjaśnia, jak używać kubectl do zarządzania obiektami. Możesz

potrzebować zainstalować kubectl, jeśli jeszcze go nie masz.

Aby dowiedzieć się więcej ogólnie o API Kubernetesa, odwiedź:

Aby dowiedzieć się więcej o obiektach w Kubernetesie, przeczytaj inne strony w tej sekcji:

3.1.2.1 - Nazwy i identyfikatory objektów

Każdy obiekt w Twoim klastrze ma Nazwę, która jest unikalna dla tego typu zasobu. Każdy obiekt Kubernetesa posiada również UID, który jest unikalny w całym Twoim klastrze.

Na przykład, w jednym namespace można mieć tylko jeden Pod o nazwie myapp-1234, ale można mieć jeden Pod i jeden Deployment, które są nazwane myapp-1234.

Dla nieunikalnych atrybutów dostarczonych przez użytkownika, Kubernetes udostępnia etykiety oraz adnotacje.

Nazwy

Ciąg znaków dostarczony przez klienta, który odnosi się do obiektu w adresie URL zasobu, na przykład /api/v1/pods/some-name.

W danym momencie tylko jeden obiekt danego typu może mieć określoną nazwę. Jednak po usunięciu tego obiektu można utworzyć nowy o tej samej nazwie.

Nazwy muszą być unikalne we wszystkich wersjach API dla tego samego zasobu. Zasoby API są rozróżniane na podstawie grupy API, typu zasobu, przestrzeni nazw (dla zasobów przestrzeniozależnych) oraz nazwy. Innymi słowy, wersja API jest nieistotna w tym kontekście.

Informacja:

W przypadkach, gdy obiekty reprezentują fizyczną jednostkę, jak Node reprezentujący fizycznego hosta, jeśli host jest odtworzony pod tą samą nazwą bez usuwania i ponownego tworzenia Node, Kubernetes traktuje nowy host jako stary, co może prowadzić do niespójności.Serwer może wygenerować nazwę, gdy zamiast name w żądaniu utworzenia zasobu podano generateName.

Gdy używane jest generateName, podana wartość służy jako prefiks nazwy, do którego serwer dodaje

wygenerowany sufiks. Nawet jeśli nazwa jest generowana, może wystąpić konflikt z istniejącymi nazwami, co

skutkuje odpowiedzią HTTP 409. W Kubernetes v1.31 i nowszych wersjach jest to znacznie mniej

prawdopodobne, ponieważ serwer podejmuje do 8 prób wygenerowania unikalnej nazwy przed zwróceniem odpowiedzi HTTP 409.

Poniżej znajdują się cztery typy często używanych ograniczeń nazw dla zasobów.

Nazwy subdomen DNS

Większość typów zasobów wymaga nazwy, która może być używana jako nazwa poddomeny DNS, zgodnie z definicją w RFC 1123. Oznacza to, że nazwa musi:

- zawierać nie więcej niż 253 znaki

- zawierać tylko małe litery alfanumeryczne, '-' lub '.'

- zaczynać się od znaku alfanumerycznego

- kończyć się znakiem alfanumerycznym

Nazwy etykiet zgodnie z RFC 1123

Niektóre typy zasobów wymagają, aby ich nazwy były zgodne ze standardem etykiet DNS, jak zdefiniowano w RFC 1123. Oznacza to, że nazwa musi:

- zawierać maksymalnie 63 znaków

- zawierać tylko małe litery alfanumeryczne lub '-'

- zaczynać się od znaku alfanumerycznego

- kończyć się znakiem alfanumerycznym

Nazwy etykiet zgodne z RFC 1035

Niektóre typy zasobów wymagają, aby ich nazwy spełniały standardy etykiet DNS zgodnie z definicją w RFC 1035. Oznacza to, że nazwa musi:

- zawierać maksymalnie 63 znaków

- zawierać tylko małe litery alfanumeryczne lub '-'

- zaczynać się od litery alfabetu

- kończyć się znakiem alfanumerycznym

Informacja:

Jedyną różnicą pomiędzy standardami etykiet RFC 1035 a RFC 1123 jest to, że etykiety RFC 1123 mogą zaczynać się od cyfry, podczas gdy etykiety RFC 1035 mogą zaczynać się jedynie od małej litery alfabetu.Nazwy segmentów ścieżki

Niektóre typy zasobów wymagają, aby ich nazwy mogły być bezpiecznie kodowane jako segment ścieżki. Innymi słowy, nazwa nie może być "." ani ".." oraz nie może zawierać "/" ani "%".

Oto przykładowy manifest dla Poda o nazwie nginx-demo.

apiVersion: v1

kind: Pod

metadata:

name: nginx-demo

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Informacja:

Niektóre typy zasobów mają dodatkowe ograniczenia dotyczące ich nazw.UIDy

Unikalny identyfikator obiektu generowany automatycznie przez system Kubernetes.

Każdy obiekt utworzony w trakcie całego cyklu życia klastra Kubernetesa posiada unikalny UID. Jego celem jest rozróżnianie historycznych wystąpień podobnych jednostek.

UID-y Kubernetesa to uniwersalne unikalne identyfikatory (znane również jako UUID). UUID są ustandaryzowane jako ISO/IEC 9834-8 oraz jako ITU-T X.667.

Co dalej?

- Przeczytaj o etykietach i adnotacjach w Kubernetesie.

- Zobacz Identyfikatory i nazwy w Kubernetesie.

3.1.2.2 - Etykiety i selektory

Etykiety to pary klucz/wartość, które są dołączane do obiektów takich jak Pody. Etykiety służą do określania identyfikacyjnych atrybutów obiektów, które są istotne i ważne dla użytkowników, ale bezpośrednio nie wpływają na semantykę głównego systemu. Etykiety mogą być używane do organizowania i wybierania podzbiorów obiektów. Etykiety mogą być dołączane do obiektów w momencie ich tworzenia, a następnie mogą być dodawane i modyfikowane w dowolnym momencie. Każdy obiekt może mieć zdefiniowany zestaw etykiet w postaci par klucz/wartość. Każdy klucz musi być unikalny dla konkretnego obiektu.

"metadata": {

"labels": {

"key1" : "value1",

"key2" : "value2"

}

}

Etykiety umożliwiają wydajne zapytania i obserwacje, co czyni je idealnym rozwiązaniem do użycia w interfejsach użytkownika (UI) i interfejsach wiersza poleceń (CLI). Informacje nieidentyfikujące powinny być rejestrowane przy użyciu adnotacji.

Motywacja

Etykiety umożliwiają użytkownikom odwzorowanie własnych struktur organizacyjnych na obiekty systemowe w sposób luźno powiązany, bez konieczności przechowywania tych odwzorowań przez klientów.

Rozmieszczanie usług i przetwarzanie wsadowe to często byty wielowymiarowe (np. wiele partycji lub wdrożeń, wiele ścieżek wydania, wiele poziomów, wiele mikrousług na poziom). Zarządzanie często wymaga operacji przekrojowych, co łamie enkapsulację ściśle hierarchicznych reprezentacji, zwłaszcza sztywnych hierarchii określanych przez infrastrukturę, a nie przez użytkowników.

Przykłady etykiet:

"release" : "stable","release" : "canary""environment" : "dev","environment" : "qa","environment" : "production""tier" : "frontend","tier" : "backend","tier" : "cache""partition" : "customerA","partition" : "customerB""track" : "daily","track" : "weekly"

Oto przykłady zalecanych etykiet ; możesz swobodnie opracowywać własne konwencje. Pamiętaj, że klucz etykiety musi być unikalny dla danego obiektu.

Składnia i zestaw znaków

Etykiety to pary klucz/wartość. Prawidłowe klucze etykiet mają dwa segmenty: opcjonalny

prefiks i nazwę, oddzielone ukośnikiem (/). Segment nazwy jest

wymagany i musi mieć maksymalnie 63 znaki, zaczynając i kończąc się znakiem

alfanumerycznym ([a-z0-9A-Z]), z myślnikami (-), podkreśleniami (_),

kropkami (.) i znakami alfanumerycznymi pomiędzy. Prefiks jest opcjonalny. Jeśli

jest podany, prefiks musi być subdomeną DNS: serią etykiet DNS oddzielonych

kropkami (.), o długości nieprzekraczającej łącznie 253 znaków, zakończoną ukośnikiem (/).

Jeśli prefiks zostanie pominięty, uważa się, że klucz etykiety jest prywatny dla użytkownika.

Zautomatyzowane komponenty systemowe (np. kube-scheduler,

kube-controller-manager, kube-apiserver, kubectl lub inne zewnętrzne

automatyzacje), które dodają etykiety do obiektów końcowego użytkownika, muszą określać prefiks.

Prefiksy kubernetes.io/ i k8s.io/ są

zarezerwowane dla podstawowych komponentów Kubernetesa.

Prawidłowa wartość etykiety:

- musi mieć 63 znaki lub mniej (może być puste),

- o ile ciąg nie jest pusty, musi zaczynać się i kończyć znakiem alfanumerycznym (

[a-z0-9A-Z]), - może zawierać myślniki (

-), podkreślenia (_), kropki (.) oraz znaki alfanumeryczne pomiędzy.

Na przykład, oto manifest dla Poda, który ma dwie

etykiety environment: production oraz app: nginx:

apiVersion: v1

kind: Pod

metadata:

name: label-demo

labels:

environment: production

app: nginx

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Selektory etykiet

W przeciwieństwie do nazw i identyfikatorów UID, etykiety nie zapewniają unikalności. To oznacza, że wiele obiektów może mieć te same etykiety.

Za pomocą selektora etykiet klient/użytkownik może zidentyfikować zestaw obiektów. Selektor etykiet jest podstawowym mechanizmem grupującym w Kubernetesie.

API obecnie obsługuje dwa typy selektorów: oparte na równości i

oparte na zbiorach. Selektor etykiet może składać się z wielu wymagań, które

są oddzielone przecinkami. W przypadku wielu wymagań, wszystkie muszą być

spełnione, więc separator przecinka działa jako logiczny operator AND (&&).

Interpretacja pustych lub niepodanych selektorów zależy od kontekstu. Każdy typ API, który je wykorzystuje, powinien jasno udokumentować ich dopuszczalność i sposób działania.

Informacja:

Dla niektórych typów API, takich jak ReplicaSets, selektory etykiet dwóch instancji nie mogą się nakładać w obrębie jednej przestrzeni nazw, ponieważ kontroler może to uznać za sprzeczne polecenia i nie będzie w stanie określić, ile replik powinno być obecnych.Uwaga:

Zarówno dla warunków opartych na równości, jak i warunków opartych na zbiorach nie istnieje operator logiczny OR (||).

Upewnij się, że twoje instrukcje filtrujące są odpowiednio skonstruowane.Wymóg oparty na równości

Wymagania oparte na równości lub nierówności umożliwiają filtrowanie

według kluczy i wartości etykiet. Pasujące obiekty muszą spełniać wszystkie

określone ograniczenia etykiet, chociaż mogą mieć również dodatkowe etykiety.

Dopuszczalne są trzy rodzaje operatorów: =,==,!=. Pierwsze dwa reprezentują

równość (i są synonimami), podczas gdy ostatni reprezentuje nierówność. Na przykład:

environment = production

tier != frontend

Poprzedni wybiera wszystkie zasoby, których klucz jest równy environment, a wartość równa się

production. Drugi wybiera wszystkie zasoby, których klucz jest równy tier, a wartość różni się od

frontend, oraz wszystkie zasoby bez etykiet z kluczem tier. Można filtrować zasoby w

production wyłączając frontend przy użyciu operatora przecinka: environment=production,tier!=frontend

Jednym ze scenariuszy użycia dla wymagań etykiet opartych na równości jest

specyfikacja kryteriów wyboru węzła przez Pody. Na przykład, poniższy przykładowy Pod wybiera

węzły, na których etykieta accelerator istnieje i jest ustawiona na nvidia-tesla-p100.

apiVersion: v1

kind: Pod

metadata:

name: cuda-test

spec:

containers:

- name: cuda-test

image: "registry.k8s.io/cuda-vector-add:v0.1"

resources:

limits:

nvidia.com/gpu: 1

nodeSelector:

accelerator: nvidia-tesla-p100

Wymagania oparte na zbiorach

Wymagania dotyczące etykiet bazujących na zbiorach (Set-based)

umożliwiają filtrowanie kluczy według zbioru wartości. Obsługiwane są trzy rodzaje

operatorów: in, notin oraz exists (tylko identyfikator klucza). Na przykład:

environment in (production, qa)

tier notin (frontend, backend)

partition

!partition

- Pierwszy przykład wybiera wszystkie zasoby z kluczem

równym

environmenti wartością równąproductionlubqa. - Drugi przykład wybiera wszystkie zasoby z kluczem równym

tieri wartościami innymi niżfrontendibackend, oraz wszystkie zasoby bez etykiet z kluczemtier. - Trzeci przykład wybiera wszystkie zasoby zawierające

etykietę z kluczem

partition; wartości nie są sprawdzane. - Czwarty przykład wybiera wszystkie zasoby bez

etykiety z kluczem

partition; wartości nie są sprawdzane.

Podobnie separator przecinka działa jako operator AND.

Filtrowanie zasobów z kluczem partition (bez względu na wartość) i z

environment innym niż qa można osiągnąć używając

partition,environment notin (qa). Selekcja etykiet oparta na zbiorach

jest ogólną formą równości, ponieważ environment=production

jest równoważne environment in (production); podobnie dla != i notin.

Wymagania oparte na zbiorach mogą być mieszane z wymaganiami opartymi na

równości. Na przykład: partition in (customerA, customerB),environment!=qa.

API

Filtrowanie LIST i WATCH

Dla operacji list i watch można określić selektory etykiet, aby filtrować zestawy zwracanych obiektów; filtr określasz za pomocą parametru zapytania. (Aby dowiedzieć się więcej o mechanizmie watch w Kubernetesie, przeczytaj o wydajnym wykrywaniu zmian ). Oba wymagania są dozwolone (przedstawione tutaj tak, jak mogą się pojawić w ciągu zapytania URL):

- wymagania oparte na równości:

?labelSelector=environment%3Dproduction,tier%3Dfrontend - _wymagania oparte na zbiorach:

?labelSelector=environment+in+%28production%2Cqa%29%2Ctier+in+%28frontend%29

Oba style selektorów etykiet mogą być używane do wylistowania lub obserwacji zasobów za pomocą klienta

REST. Na przykład, kierując się na apiserver z kubectl i używając selekcji opartej na równości, można napisać:

kubectl get pods -l environment=production,tier=frontend

lub używając wymagań opartych na zbiorach:

kubectl get pods -l 'environment in (production),tier in (frontend)'

Jak już wspomniano, wymagania oparte na zbiorach są bardziej wyraziste. Na przykład mogą implementować operator LUB na wartościach:

kubectl get pods -l 'environment in (production, qa)'

lub ograniczenie dopasowywania negatywnego za pomocą operatora notin:

kubectl get pods -l 'environment,environment notin (frontend)'

Ustaw referencje w obiektach API

Niektóre obiekty Kubernetesa, takie jak

services i replicationcontrollers,

również używają selektorów etykiet do

określania zbiorów innych zasobów, takich jak pods.

Usługa i Kontroler Replikacji

Zestaw podów, na które skierowana jest usługa (service), jest określany za pomocą selektora

etykiet. Podobnie, populacja podów, którą powinien zarządzać kontroler

replikacji (replicationcontroller), jest również określana za pomocą selektora etykiet.

Selektory etykiet dla obu obiektów są definiowane w plikach json lub

yaml za pomocą map, i obsługiwane są tylko selektory wymagań oparte na równości:

"selector": {

"component" : "redis",

}

lub

selector:

component: redis

Ten selektor (odpowiednio w formacie json lub yaml)

jest równoważny z component=redis lub component in (redis).

Zasoby, które obsługują wymagania oparte na zbiorach

Nowsze zasoby, takie jak Job,

Deployment,

ReplicaSet

oraz DaemonSet,

obsługują również wymagania oparte na zbiorach.

selector:

matchLabels:

component: redis

matchExpressions:

- { key: tier, operator: In, values: [cache] }

- { key: environment, operator: NotIn, values: [dev] }

matchLabels to mapa par {klucz,wartość}. Pojedyncza para {klucz,wartość} w

mapie matchLabels jest równoważna elementowi matchExpressions, którego pole

key to "klucz", operator to "In", a tablica values zawiera wyłącznie "wartość". matchExpressions

to lista wymagań selektora podów. Prawidłowe operatory to In,

NotIn, Exists i DoesNotExist. Zbiór wartości musi być niepusty w przypadku In i

NotIn. Wszystkie wymagania zarówno z matchLabels, jak i matchExpressions są

łączone za pomocą operatora AND - muszą być wszystkie spełnione, aby dopasowanie było możliwe.

Wybieranie zestawów węzłów

Jednym z przypadków użycia wybierania w oparciu o etykiety jest ograniczenie zestawu węzłów, na które można umieścić pod. Więcej informacji można znaleźć w dokumentacji na temat wyboru węzła.

Skuteczne wykorzystywanie etykiet

Możesz zastosować pojedynczą etykietę do dowolnych zasobów, ale nie zawsze jest to najlepsza praktyka. Istnieje wiele scenariuszy, w których należy użyć wielu etykiet, aby odróżnić zestawy zasobów od siebie nawzajem.

Na przykład różne aplikacje mogą używać różnych wartości dla etykiety app, ale aplikacja

wielowarstwowa, taka jak przykład książki gości,

będzie dodatkowo musiała rozróżniać każdą warstwę. Frontend mógłby nosić następujące etykiety:

labels:

app: guestbook

tier: frontend

podczas gdy instancje master i replica Redis miałyby różne etykiety

tier, a być może nawet dodatkową etykietę role:

labels:

app: guestbook

tier: backend

role: master

i

labels:

app: guestbook

tier: backend

role: replica

Etykiety umożliwiają sortowanie i filtrowanie zasobów według dowolnego wymiaru określonego przez etykietę:

kubectl apply -f examples/guestbook/all-in-one/guestbook-all-in-one.yaml

kubectl get pods -Lapp -Ltier -Lrole

NAME READY STATUS RESTARTS AGE APP TIER ROLE

guestbook-fe-4nlpb 1/1 Running 0 1m guestbook frontend <none>

guestbook-fe-ght6d 1/1 Running 0 1m guestbook frontend <none>

guestbook-fe-jpy62 1/1 Running 0 1m guestbook frontend <none>

guestbook-redis-master-5pg3b 1/1 Running 0 1m guestbook backend master

guestbook-redis-replica-2q2yf 1/1 Running 0 1m guestbook backend replica

guestbook-redis-replica-qgazl 1/1 Running 0 1m guestbook backend replica

my-nginx-divi2 1/1 Running 0 29m nginx <none> <none>

my-nginx-o0ef1 1/1 Running 0 29m nginx <none> <none>

kubectl get pods -lapp=guestbook,role=replica

NAME READY STATUS RESTARTS AGE

guestbook-redis-replica-2q2yf 1/1 Running 0 3m

guestbook-redis-replica-qgazl 1/1 Running 0 3m

Aktualizacja etykiet

Czasami możesz chcieć zmienić etykiety istniejących podów i innych zasobów przed

utworzeniem nowych zasobów. Można to zrobić za pomocą kubectl label. Na

przykład, jeśli chcesz oznaczyć wszystkie swoje pody NGINX jako warstwę frontendową, wykonaj:

kubectl label pods -l app=nginx tier=fe

pod/my-nginx-2035384211-j5fhi labeled

pod/my-nginx-2035384211-u2c7e labeled

pod/my-nginx-2035384211-u3t6x labeled

Najpierw filtruje wszystkie pody z etykietą "app=nginx", a następnie nadaje im etykietę "tier=fe". Aby zobaczyć pody, które zostały oznaczone etykietą, uruchom:

kubectl get pods -l app=nginx -L tier

NAME READY STATUS RESTARTS AGE TIER

my-nginx-2035384211-j5fhi 1/1 Running 0 23m fe

my-nginx-2035384211-u2c7e 1/1 Running 0 23m fe

my-nginx-2035384211-u3t6x 1/1 Running 0 23m fe

To wyświetla wszystkie pody z etykietą "app=nginx", z dodatkową kolumną

etykiet reprezentującą warstwę podów (określoną za pomocą -L lub --label-columns).

Aby uzyskać więcej informacji, zobacz kubectl label.

Co dalej?

- Dowiedz się, jak dodać etykietę do węzła

- Zobacz Well-known labels, Annotations and Taints

- Zobacz Zalecane etykiety

- Enforce Pod Security Standards with Namespace Labels

- Przeczytaj blog Writing a Controller for Pod Labels

3.1.2.3 - Przestrzenie nazw (ang. Namespaces)

W Kubernetesie przestrzenie nazw zapewniają mechanizm izolowania grup zasobów w ramach jednego klastra. Nazwy zasobów muszą być unikalne w obrębie danej przestrzeni nazw, ale nie muszą być unikalne w całym klastrze. Zakres oparty na przestrzeniach nazw dotyczy tylko obiektów (np. Deploymentów, Service'ów, itp.), a nie dla obiektów dotyczących całego klastra (np. StorageClass, Nodes, PersistentVolumes, itp.).

Kiedy używać wielu przestrzeni nazw

Przestrzenie nazw są przeznaczone do użycia w środowiskach z wieloma użytkownikami rozproszonymi w różnych zespołach lub projektach. Dla klastrów z użytkownikami w ilości od kilku do kilkunastu nie powinieneś potrzebować tworzyć ani myśleć o przestrzeniach nazw. Zacznij używać przestrzeni nazw, gdy potrzebujesz funkcji, które one oferują.

Namespace'y zapewniają zakres dla nazw. Nazwy zasobów muszą być unikalne w obrębie jednego namespace'u, ale nie muszą być unikalne w różnych namespace'ach. Namespace'y nie mogą być zagnieżdżane w sobie wzajemnie, a każdy zasób Kubernetesa może znajdować się tylko w jednym namespace'ie.

Namespacey są sposobem na podział zasobów klastra pomiędzy wielu użytkowników (przez resource quotas).

Nie ma potrzeby używania wielu przestrzeni nazw do oddzielania nieznacznie różniących się zasobów, takich jak różne wersje tego samego oprogramowania: zamiast tego wykorzystaj etykiety, aby rozróżnić zasoby w obrębie jednej przestrzeni nazw.

Informacja:

Dla klastra produkcyjnego, rozważ nie używanie przestrzeni nazwdefault. Zamiast tego stwórz inne przestrzenie nazw i używaj ich.Początkowe przestrzenie nazw

Kubernetes rozpoczyna z czterema początkowymi przestrzeniami nazw:

default : Kubernetes zawiera tę przestrzeń nazw, aby umożliwić rozpoczęcie

korzystania z nowego klastra bez konieczności wcześniejszego tworzenia przestrzeni nazw.

kube-node-lease : Ta przestrzeń nazw przechowuje obiekty Lease powiązane z każdym węzłem. Pozwalają one kubeletowi

na wysyłanie sygnałów życia (ang. heartbeats), dzięki czemu warstwa sterowania może wykryć awarię węzła.

kube-public : Ta przestrzeń nazw jest możliwa do odczytu przez wszystkich klientów (w tym tych, którzy nie są uwierzytelnieni). Ta przestrzeń nazw jest głównie zarezerwowana do

użytku klastra, na wypadek gdyby niektóre zasoby miały być widoczne i czytelne publicznie w całym klastrze. Publiczny aspekt tej przestrzeni nazw jest jedynie konwencją, a nie wymogiem.

kube-system : Przestrzeń nazw dla

obiektów tworzonych przez system Kubernetesa.

Praca z przestrzeniami nazw

Tworzenie i usuwanie przestrzeni nazw zostało opisane w dokumentacji Przewodnika Administratora dotyczącej przestrzeni nazw.

Informacja:

Unikaj tworzenia przestrzeni nazw z prefiksemkube-, ponieważ jest on zarezerwowany dla przestrzeni nazw systemu Kubernetes.Przeglądanie przestrzeni nazw

Możesz wyświetlić listę bieżących przestrzeni nazw w klastrze za pomocą:

kubectl get namespace

NAME STATUS AGE

default Active 1d

kube-node-lease Active 1d

kube-public Active 1d

kube-system Active 1d

Ustawianie przestrzeni nazw dla żądania

Aby ustawić przestrzeń nazw dla bieżącego żądania, użyj flagi --namespace.

Na przykład:

kubectl run nginx --image=nginx --namespace=<insert-namespace-name-here>

kubectl get pods --namespace=<insert-namespace-name-here>

Ustawianie preferencji przestrzeni nazw

Możesz na stałe zapisać przestrzeń nazw dla wszystkich kolejnych poleceń kubectl w tym kontekście.

kubectl config set-context --current --namespace=<insert-namespace-name-here>

# Validate it

kubectl config view --minify | grep namespace:

Przestrzenie nazw i DNS

Kiedy tworzysz Service, tworzy on

odpowiadający mu rekord DNS.

Ten wpis ma postać <service-name>.<namespace-name>.svc.cluster.local, co oznacza,

że jeśli kontener używa tylko <service-name>, odwołuje się on do usługi lokalnej

dla danego namespace'a. Jest to przydatne do używania tej samej konfiguracji w

wielu namespace'ach, takich jak Development, Staging i Production. Jeśli chcesz uzyskać dostęp

do zasobów między namespace'ami, musisz użyć w pełni kwalifikowanej nazwy domeny (FQDN).

W związku z tym, wszystkie nazwy przestrzeni nazw muszą być zgodne z etykietami DNS RFC 1123.

Ostrzeżenie:

Poprzez tworzenie przestrzeni nazw o takiej samej nazwie jak publiczne domeny najwyższego poziomu, usługi w tych przestrzeniach nazw mogą mieć krótkie nazwy DNS, które pokrywają się z publicznymi rekordami DNS. Zapytania DNS wykonywane przez workloady z dowolnej przestrzeni nazw, bez kończącej kropki, będą przekierowane do tych usług, mając pierwszeństwo przed publicznym wpisem DNS.

Aby temu zapobiec, ogranicz uprawnienia do tworzenia przestrzeni nazw dla zaufanych użytkowników. Jeśli to konieczne, możesz dodatkowo skonfigurować zewnętrzne mechanizmy kontroli bezpieczeństwa, takie jak admission webhooks, aby zablokować tworzenie jakiejkolwiek przestrzeni nazw o nazwie z listy domen najwyższego poziomu (ang. TLD - Top-Level Domain).

Nie wszystkie obiekty znajdują się w przestrzeni nazw.

Większość zasobów Kubernetesa (np. pody, usługi, kontrolery replikacji i inne) znajduje się w jakiś przestrzeniach nazw. Jednak zasoby przestrzeni nazw nie są same w sobie w przestrzeni nazw. Zasoby niskiego poziomu, takie jak węzły i persistentVolumes, nie znajdują się w żadnej przestrzeni nazw.

Aby zobaczyć, które zasoby Kubernetesa znajdują się w przestrzeni nazw, a które nie:

# In a namespace

kubectl api-resources --namespaced=true

# Not in a namespace

kubectl api-resources --namespaced=false

Automatyczne etykietowanie

Kubernetes 1.22 [stable]Warstwa sterowania Kubernetesa ustawia niezmienną

etykietę kubernetes.io/metadata.name na

wszystkich przestrzeniach nazw. Wartością etykiety jest nazwa przestrzeni nazw.

Co dalej?

- Dowiedz się więcej o tworzeniu przestrzeni nazw.

- Dowiedz się więcej o usuwaniu przestrzeni nazw.

3.1.2.4 - Adnotatcje

Możesz używać Kubernetesowych adnotacji do dołączania dodatkowych (czyli takich, które nie są wykorzystywane przy identyfikacji) metadanych do obiektów. Narzędzia i biblioteki mogą odczytywać te metadane.

Dołączanie metadanych do obiektów

Możesz używać etykiet (ang. labels) lub adnotacji (ang. annotations), aby dołączać metadane do obiektów Kubernetesa. Etykiety pomagają w wybieraniu obiektów i wyszukiwaniu ich zbiorów na podstawie określonych warunków. Z kolei adnotacje nie są używane do identyfikacji ani selekcji obiektów. Metadane w adnotacjach mogą mieć dowolny rozmiar i strukturę - mogą być małe lub duże, uporządkowane lub nie, i zawierać znaki niedozwolone w etykietach. Dopuszczalne jest jednoczesne użycie etykiet i adnotacji w tym samym obiekcie.

Adnotacje, podobnie jak etykiety, są mapami klucz/wartość:

"metadata": {

"annotations": {

"key1" : "value1",

"key2" : "value2"

}

}

Informacja:

Klucze i wartości w mapie muszą być ciągami znaków. Innymi słowy, nie można używać wartości numerycznych, logicznych, list ani innych typów ani dla kluczy, ani dla wartości.Oto przykłady informacji, które mogą być zapisane w adnotacjach:

Pola zarządzane przez warstwę konfiguracji deklaratywnej. Dołączanie tych pól jako adnotacji odróżnia je od wartości domyślnych ustawianych przez klientów lub serwery, oraz od pól generowanych automatycznie i pól ustawianych przez systemy automatycznego skalowania lub automatycznego dopasowywania rozmiaru.

Informacje dotyczące kompilacji, wersji lub obrazów, takie jak znaczniki czasu, identyfikatory wersji, gałąź git, numery PR, skróty obrazów i adres rejestru.

Referencje do zewnętrznych źródeł danych takich jak logi, metryki monitorujące, wyniki analiz czy dane audytowe.

Informacje o bibliotece klienckiej lub narzędziu, które mogą być wykorzystane do debugowania - na przykład nazwa, wersja i dane o kompilacji.

Informacje o pochodzeniu użytkownika, narzędzia lub systemu, takie jak adresy URL powiązanych obiektów z innych komponentów ekosystemu.

Metadane wykorzystywane przez proste narzędzia do wdrażania zmian (rollout), takie jak zapis stanu konfiguracji lub punktów kontrolnych służących do śledzenia postępu wdrożenia.

Numery telefonów lub pagerów osób odpowiedzialnych, lub wpisy do katalogu określające, gdzie można znaleźć te informacje, takie jak strona internetowa zespołu.

Instrukcje od użytkownika końcowego kierowane do implementacji, mające na celu zmianę zachowania systemu lub uruchomienie niestandardowych funkcji.

Zamiast używać adnotacji, można przechowywać tego typu informacje w zewnętrznej bazie danych lub katalogu, ale to znacznie utrudniłoby tworzenie wspólnych bibliotek klienckich i narzędzi do wdrażania, zarządzania, introspekcji i tym podobnych działań.

Składnia i zestaw znaków

Adnotacje są parami klucz/wartość. Prawidłowe klucze adnotacji mają dwa segmenty: opcjonalny prefiks oraz nazwę, oddzielone ukośnikiem (/). Segment nazwy jest wymagany i musi mieć maksymalnie 63 znaki, zaczynać się i kończyć znakiem alfanumerycznym ([a-z0-9A-Z]) oraz może zawierać myślniki (-), podkreślenia (_), kropki (.) i znaki alfanumeryczne pomiędzy nimi. Prefiks jest opcjonalny. Jeśli zostanie określony, prefiks musi być subdomeną DNS: serią etykiet DNS oddzielonych kropkami (.), nie dłuższą w sumie niż 253 znaki, zakończoną ukośnikiem (/).

Jeśli prefiks jest pominięty, zakłada się, że klucz adnotacji należy wyłącznie do użytkownika. Zautomatyzowane komponenty systemowe (np. kube-scheduler, kube-controller-manager, kube-apiserver, kubectl lub inna automatyzacja firm trzecich), które dodają adnotacje do obiektów końcowego użytkownika, muszą określić prefiks.

Prefiksy kubernetes.io/ i k8s.io/ są zarezerwowane dla podstawowych komponentów Kubernetesa.

Na przykład, oto manifest dla Poda, który posiada adnotację imageregistry: https://hub.docker.com/ :

apiVersion: v1

kind: Pod

metadata:

name: annotations-demo

annotations:

imageregistry: "https://hub.docker.com/"

spec:

containers:

- name: nginx

image: nginx:1.14.2

ports:

- containerPort: 80

Co dalej?

- Dowiedz się więcej o Etykietach i Selektorach.

- Znajdź Typowe etykiety, Adnotacje i Tainty (ang. Taints)

3.1.2.5 - Selektory pól

Selektory pól (Field selectors) pozwalają na wybór obiektów Kubernetesa na podstawie wartości jednego lub kilku pól zasobów. Oto kilka przykładów zapytań z użyciem selektora pól:

metadata.name=my-servicemetadata.namespace!=defaultstatus.phase=Pending

Polecenie kubectl wybiera wszystkie Pody, dla których wartość pola status.phase to Running:

kubectl get pods --field-selector status.phase=Running

Informacja:

Selektory pól to zasadniczo filtry zasobów. Domyślnie nie stosuje się żadnych selektorów/filtrów, co oznacza, że wszystkie zasoby określonego typu są wybierane. Dzięki temu zapytaniakubectl kubectl get pods i kubectl get pods --field-selector "" są równoważne.Obsługiwane pola

Obsługiwane selektory pól różnią się w zależności od typu zasobu Kubernetesa. Wszystkie typy zasobów obsługują pola metadata.name oraz metadata.namespace. Użycie nieobsługiwanych selektorów pól skutkuje błędem. Na przykład:

kubectl get ingress --field-selector foo.bar=baz

Error from server (BadRequest): Unable to find "ingresses" that match label selector "", field selector "foo.bar=baz": "foo.bar" is not a known field selector: only "metadata.name", "metadata.namespace"

Lista obsługiwanych pól

| Rodzaj | Pola |

|---|---|

| Pod | spec.nodeNamespec.restartPolicyspec.schedulerNamespec.serviceAccountNamespec.hostNetworkstatus.phasestatus.podIPstatus.podIPsstatus.nominatedNodeName |

| Event | involvedObject.kindinvolvedObject.namespaceinvolvedObject.nameinvolvedObject.uidinvolvedObject.apiVersioninvolvedObject.resourceVersioninvolvedObject.fieldPathreasonreportingComponentsourcetype |

| Secret | type |

| Namespace | status.phase |

| ReplicaSet | status.replicas |

| ReplicationController | status.replicas |

| Job | status.successful |

| Node | spec.unschedulable |

| CertificateSigningRequest | spec.signerName |

Pola zasobów niestandardowych

Wszystkie niestandardowe typy zasobów obsługują pola metadata.name oraz metadata.namespace.

Dodatkowo, pole spec.versions[*].selectableFields w CustomResourceDefinition określa,

które inne pola w zasobie niestandardowym mogą być używane w selektorach pól. Zobacz

selectable fields for custom resources aby uzyskać więcej informacji o tym, jak używać selektorów pól z CustomResourceDefinitions.

Obsługiwane operatory

Możesz używać operatorów =, == i != z selektorami pól (= and == oznaczają to samo). Na przykład ta komenda kubectl wybiera wszystkie usługi Kubernetesa, które nie znajdują się w przestrzeni nazw default:

kubectl get services --all-namespaces --field-selector metadata.namespace!=default

Informacja:

Operatory dla zbiorów (Set-based operators ) (in, notin, exists) nie są obsługiwane dla selektorów pól.Złożone selektory

Podobnie jak etykieta i inne selektory, selektory pól mogą być łączone w postaci listy rozdzielanej przecinkami. To polecenie kubectl wybiera wszystkie Pody, dla których status.phase nie jest równe Running, a pole spec.restartPolicy jest równe Always:

kubectl get pods --field-selector=status.phase!=Running,spec.restartPolicy=Always

Wiele typów zasobów

Możesz używać selektorów pól w różnych typach zasobów. To polecenie kubectl wybiera wszystkie obiekty typu Statefulset i Service, które nie znajdują się w przestrzeni nazw default:

kubectl get statefulsets,services --all-namespaces --field-selector metadata.namespace!=default

3.1.3 - API Kubernetesa

Sercem warstwy sterowania Kubernetesa jest serwer API. Serwer udostępnia API poprzez HTTP, umożliwiając wzajemną komunikację pomiędzy użytkownikami, częściami składowymi klastra i komponentami zewnętrznymi.

API Kubernetesa pozwala na sprawdzanie i zmianę stanu obiektów (przykładowo: pody, Namespaces, ConfigMaps, Events).

Większość operacji może zostać wykonana poprzez interfejs linii komend (CLI) kubectl lub inne programy, takie jak kubeadm, które używają API. Możesz też korzystać z API bezpośrednio przez wywołania typu REST. Jeśli piszesz aplikację używającą API Kubernetesa, warto rozważyć użycie jednej z bibliotek klienckich.

Każdy klaster Kubernetesa publikuje specyfikację dostępnych interfejsów API. Dostępne

są dwa mechanizmy udostępniania tych specyfikacji, które

umożliwiają automatyczną integrację i interoperacyjność z narzędziami zewnętrznymi.

Na przykład narzędzie kubectl pobiera i buforuje specyfikację API w celu

umożliwienia autouzupełniania wiersza poleceń i innych funkcji. Te dwa mechanizmy to:

Discovery API dostarcza informacji o interfejsach API Kubernetesa: nazwach API, zasobach, wersjach i obsługiwanych operacjach. W Kubernetesie ten termin ma szczególne znaczenie, ponieważ to odrębny interfejs od OpenAPI i jest traktowany jako osobna część systemu. Jest to zwięzłe podsumowanie dostępnych zasobów i nie obejmuje szczegółowych definicji schematów. Szczegółowe informacje o strukturze zasobów można znaleźć w dokumencie OpenAPI.

Kubernetes OpenAPI Document dostarcza (pełne) schematy OpenAPI v2.0 i 3.0 dla wszystkich endpointów API Kubernetesa. OpenAPI v3 to zalecany sposób uzyskiwania dostępu do specyfikacji API, ponieważ zapewnia pełniejszy i dokładniejszy obraz. Zawiera wszystkie ścieżki API oraz komplet danych wejściowych i wyjściowych dla każdej operacji na wszystkich endpointach. Specyfikacja obejmuje także wszystkie rozszerzenia wspierane przez klaster. Jest to pełna definicja API, która znacząco przewyższa pod względem szczegółowości dane z Discovery API.

Discovery API

Kubernetes przez Discovery API udostępnia pełną listę obsługiwanych grup API, ich wersji oraz zasobów. Dla każdego zasobu można uzyskać następujące dane:

- Nazwa

- Klaster lub zasięg w przestrzeni nazw

- URL endpointu oraz obsługiwane metody HTTP

- Alternatywne nazwy

- Grupa, wersja, typ

API jest dostępne zarówno w formie zagregowanej, jak i niezagregowanej. W trybie zagregowanym Discovery API udostępnia dwa endpointy, natomiast w trybie niezagregowanym jest to oddzielny endpoint dla każdej wersji grupy.

Zagregowane Discovery API

Kubernetes v1.30 [stable](enabled by default)Kubernetes zapewnia stabilne wsparcie dla zagregowanego

Discovery API, publikując wszystkie zasoby obsługiwane przez klaster za

pośrednictwem dwóch endpointów (/api i /apis).

Korzystanie z tych endpointów znacząco ogranicza liczbę zapytań

potrzebnych do pobrania danych z klastra. Dostęp do tych danych

uzyskuje się, wysyłając żądanie na odpowiedni endpoint z

nagłówkiem Accept, który wskazuje na zagregowany zasób Discovery:

Accept: application/json;v=v2;g=apidiscovery.k8s.io;as=APIGroupDiscoveryList.

W przypadku braku nagłówka Accept wskazującego

typ zasobu, zapytania do endpointów /api i

/apis zwracają domyślnie dane w formacie niezagregowanym.

Discovery document znajduje się w oficjalnym repozytorium GitHub Kubernetesa. Może on służyć jako odniesienie do podstawowego zestawu zasobów dostępnych w Kubernetesie, gdy nie masz możliwości wykonania zapytania do rzeczywistego klastra.

Endpoint obsługuje także mechanizm ETag oraz możliwość przesyłania danych w formacie protobuf.

Niezagregowane Discovery API

W przypadku braku agregacji Discovery API, dane udostępniane są w strukturze wielopoziomowej, w której główne endpointy publikują informacje prowadzące do podrzędnych dokumentów.

Wszystkie wersje grup API dostępnych w klastrze są udostępniane pod endpointami /api i /apis. Oto przykład:

{

"kind": "APIGroupList",

"apiVersion": "v1",

"groups": [

{

"name": "apiregistration.k8s.io",

"versions": [

{

"groupVersion": "apiregistration.k8s.io/v1",

"version": "v1"

}

],

"preferredVersion": {

"groupVersion": "apiregistration.k8s.io/v1",

"version": "v1"

}

},

{

"name": "apps",

"versions": [

{

"groupVersion": "apps/v1",

"version": "v1"

}

],

"preferredVersion": {

"groupVersion": "apps/v1",

"version": "v1"

}

},

...

}

Żeby pobrać informacje o zasobach dostępnych w konkretnej

wersji API, trzeba wysłać osobne zapytanie pod

/apis/<group>/<version> - np. /apis/rbac.authorization.k8s.io/v1alpha1. Ten

endpoint zawiera listę typów zasobów w danej grupie. Używa go

polecenie kubectl, żeby dowiedzieć się, jakie zasoby są dostępne w klastrze.

Interfejs OpenAPI

Pełną specyfikację API udokumentowano za pomocą OpenAPI.

Kubernetes obsługuje zarówno OpenAPI 2.0, jak i 3.0. Wersja

3 jest preferowana, ponieważ umożliwia

dokładniejszy i kompletny opis zasobów (bez utraty

informacji). W OpenAPI 2 niektóre pola, np. default,

nullable, oneOf, są pomijane z powodu ograniczeń formatu.

OpenAPI V2

Serwer API Kubernetesa udostępnia specyfikację

OpenAPI poprzez ścieżkę /openapi/v2. Aby wybrać

format odpowiedzi, użyj nagłówków żądania zgodnie z tabelą:

| Nagłówek | Dopuszczalne wartości | Uwagi |

|---|---|---|

Accept-Encoding | gzip | pominięcie tego nagłówka jest dozwolone |

Accept | application/com.github.proto-openapi.spec.v2@v1.0+protobuf | głównie do celu komunikacji wewnątrz klastra |

application/json | domyślne | |

* | udostępnia application/json |

Ostrzeżenie:

Reguły walidacyjne publikowane w ramach schematów OpenAPI mogą być niekompletne – i zazwyczaj nie zawierają wszystkich warunków. Dodatkowa walidacja realizowana jest przez serwer API. Aby uzyskać pełną i precyzyjną weryfikację, zaleca się użycie poleceniakubectl apply --dry-run=server, które uruchamia wszystkie

mechanizmy walidacji, również te wykonujące się podczas przyjmowania zasobów do klastra (ang. admission checks).OpenAPI V3

Kubernetes v1.27 [stable](enabled by default)Kubernetes publikuje własne API zgodnie ze specyfikacją OpenAPI v3.

Pod adresem /openapi/v3 można znaleźć listę wszystkich

dostępnych grup/wersji. Zwracane wartości są dostępne tylko w formacie

JSON. Grupy/wersje opisane są następującym schematem:

{

"paths": {

...,

"api/v1": {

"serverRelativeURL": "/openapi/v3/api/v1?hash=CC0E9BFD992D8C59AEC98A1E2336F899E8318D3CF4C68944C3DEC640AF5AB52D864AC50DAA8D145B3494F75FA3CFF939FCBDDA431DAD3CA79738B297795818CF"

},

"apis/admissionregistration.k8s.io/v1": {

"serverRelativeURL": "/openapi/v3/apis/admissionregistration.k8s.io/v1?hash=E19CC93A116982CE5422FC42B590A8AFAD92CDE9AE4D59B5CAAD568F083AD07946E6CB5817531680BCE6E215C16973CD39003B0425F3477CFD854E89A9DB6597"

},

....

}

}

Względne adresy URL wskazują na niezmieniające się opisy OpenAPI, aby umożliwić

trzymanie cache po stronie klienta. Serwer API zwraca

również odpowiednie nagłówki HTTP dla cache (Expires ustawione na 1 rok wprzód,

Cache-Control jako immutable). Wysłanie zapytania do

nieaktualnego URL spowoduje przekierowanie przez serwer API do wersji najnowszej.

Serwer API Kubernetesa udostępnia specyfikację

OpenAPI v3 pod adresem /openapi/v3/apis/<group>/<version>?hash=<hash>,

zgodnie z podziałem na grupy i wersje.

Tabela poniżej podaje dopuszczalne wartości nagłówków żądania.

| Nagłówek | Dopuszczalne wartości | Uwagi |

|---|---|---|

Accept-Encoding | gzip | pominięcie tego nagłówka jest dozwolone |

Accept | application/com.github.proto-openapi.spec.v3@v1.0+protobuf | głównie do celu komunikacji wewnątrz klastra |

application/json | domyślne | |

* | udostępnia application/json |

W pakiecie k8s.io/client-go/openapi3

znajduje się implementacja w Golang do pobierania OpenAPI V3.

Kubernetes 1.35 publikuje OpenAPI w wersji 2.0 i 3.0; nie ma planów wsparcia wersji 3.1 w najbliższej przyszłości.

Serializacja Protobuf

Kubernetes implementuje alternatywny format serializacji oparty na Protobuf, który jest głównie przeznaczony do komunikacji w obrębie klastra. Aby uzyskać więcej informacji na temat tego formatu, zobacz Kubernetes Protobuf serialization propozycję projektową oraz pliki Interface Definition Language (IDL) dla każdego schematu znajdujące się w pakietach Go, które definiują obiekty API.

Przechowywanie stanu

Kubernetes przechowuje serializowany stan swoich obiektów w etcd.

Grupy i wersje API

Aby ułatwić usuwanie poszczególnych pól lub restrukturyzację reprezentacji

zasobów, Kubernetes obsługuje równocześnie wiele wersji API, każde poprzez osobną

ścieżkę API, na przykład: /api/v1 lub /apis/rbac.authorization.k8s.io/v1alpha1.

Rozdział wersji wprowadzony jest na poziomie całego API, a nie na poziomach poszczególnych zasobów lub pól, aby być pewnym, że API odzwierciedla w sposób przejrzysty i spójny zasoby systemowe i ich zachowania oraz pozwala na kontrolowany dostęp do tych API, które są w fazie wycofywania lub fazie eksperymentalnej.

Aby ułatwić rozbudowę API Kubernetes, wprowadziliśmy grupy API, które mogą być włączane i wyłączane.

Zasoby API są rozróżniane poprzez przynależność do grupy API, typ zasobu, przestrzeń nazw (namespace, o ile ma zastosowanie) oraz nazwę. Serwer API może przeprowadzać konwersję między różnymi wersjami API w sposób niewidoczny dla użytkownika: wszystkie te różne wersje reprezentują w rzeczywistości ten sam zasób. Serwer API może udostępniać te same dane poprzez kilka różnych wersji API.

Załóżmy przykładowo, że istnieją dwie wersje v1 i v1beta1 tego

samego zasobu. Obiekt utworzony przez wersję v1beta1 może być

odczytany, zaktualizowany i skasowany zarówno przez wersję v1beta1,

jak i v1, do czasu aż wersja v1beta1 będzie przestarzała i

usunięta. Wtedy możesz dalej korzystać i modyfikować obiekt poprzez wersję v1.

Zmiany w API

Z naszego doświadczenia wynika, że każdy system, który odniósł sukces, musi się nieustająco rozwijać w miarę zmieniających się potrzeb. Dlatego Kubernetes został tak zaprojektowany, aby API mogło się zmieniać i rozrastać. Projekt Kubernetes dąży do tego, aby nie wprowadzać zmian niezgodnych z istniejącymi aplikacjami klienckimi i utrzymywać zgodność przez wystarczająco długi czas, aby inne projekty zdążyły się dostosować do zmian.

W ogólności, nowe zasoby i pola definiujące zasoby API są dodawane stosunkowo często. Usuwanie zasobów lub pól jest regulowane przez API deprecation policy.

Po osiągnięciu przez API statusu ogólnej dostępności (general availability - GA), oznaczanej

zazwyczaj jako wersja API v1, bardzo zależy nam na utrzymaniu jej zgodności w kolejnych wydaniach.

Dodatkowo, Kubernetes zachowuje kompatybilność z danymi zapisanymi za pomocą wersji beta. Gdy dana

funkcja osiąga stabilność (GA), dane te mogą być automatycznie konwertowane i dostępne w docelowej wersji API.

Jeśli korzystasz z wersji beta API, musisz przejść na kolejną wersję beta lub stabilną, gdy dana wersja zostanie wycofana. Najlepszy moment na migrację to okres wycofywania wersji beta - wtedy obiekty są dostępne równocześnie w obu wersjach API. Po zakończeniu tego okresu wersja beta przestaje być obsługiwana i konieczne jest użycie wersji docelowej.

Informacja:

Mimo, że Kubernetes stara się także zachować zgodność dla API w wersji alpha, zdarzają się przypadki, kiedy nie jest to możliwe. Jeśli korzystasz z API w wersji alfa, przed aktualizacją klastra do nowej wersji zalecamy sprawdzenie w informacjach o wydaniu, czy nie nastąpiła jakaś zmiana w tej części API. Może się okazać, że API uległo niekompatybilnym zmianom, co wymaga usunięcia wszystkich istniejących obiektów alfa przed wykonaniem aktualizacji.Zajrzyj do API versions reference po szczegółowe definicje różnych poziomów wersji API.

Rozbudowa API

API Kubernetesa można rozszerzać na dwa sposoby:

- Definicje zasobów własnych (custom resources) pozwalają deklaratywnie określać, jak serwer API powinien dostarczać wybrane przez Ciebie zasoby API.

- Można także rozszerzać API Kubernetesa implementując warstwę agregacji.

Co dalej?

- Naucz się, jak rozbudowywać API Kubernetesa poprzez dodawanie własnych CustomResourceDefinition.

- Controlling Access To The Kubernetes API opisuje sposoby, jakimi klaster zarządza dostępem do API.

- Punkty dostępowe API (endpoints), typy zasobów i przykłady zamieszczono w API Reference.

- Aby dowiedzieć się, jaki rodzaj zmian można określić jako zgodne i jak zmieniać API, zajrzyj do API changes.

3.2 - Architektura klastra

Klaster Kubernetesa składa się z warstwy sterowania oraz zestawu maszyn roboczych, zwanych węzłami, które uruchamiają konteneryzowane aplikacje. Każdy klaster potrzebuje co najmniej jednego węzła roboczego, aby obsługiwać Pody.

Węzeł roboczy hostuje Pody, które są komponentami workload aplikacji. Warstwa sterowania zarządza węzłami roboczymi oraz Podami w klastrze. W środowiskach produkcyjnych, warstwa sterowania zazwyczaj działa na wielu komputerach, a klaster zazwyczaj działa na wielu węzłach, zapewniając odporność na awarie i wysoką dostępność.

Ten dokument opisuje różne komponenty, które musisz posiadać, aby mieć kompletny i działający klaster Kubernetesa.

Rysunek 1. Komponenty klastra Kubernetesa.

About this architecture

Diagram na Rysunku 1 przedstawia przykładową referencyjną architekturę klastra Kubernetesa. Rzeczywisty rozkład komponentów może różnić się w zależności od specyficznych konfiguracji klastra i wymagań.

Na schemacie każdy węzeł uruchamia komponent kube-proxy.

Potrzebujesz komponentu sieciowego proxy na każdym węźle, aby

zapewnić, że API Service i

związane z nim zachowania są dostępne w sieci klastra. Niektóre wtyczki

sieciowe jednak dostarczają własne, zewnętrzne implementacje proxy. Kiedy

korzystasz z tego rodzaju wtyczki sieciowej, węzeł nie musi uruchamiać kube-proxy.

Komponenty warstwy sterowania

Komponenty warstwy sterowania podejmują globalne decyzje dotyczące klastra (na

przykład harmonogramowanie), a także wykrywają i reagują na zdarzenia klastra (na

przykład uruchamianie nowego poda gdy nie

zgadza się liczba replik Deploymentu.

Elementy warstwy sterowania mogą być uruchamiane na dowolnej maszynie w klastrze. Jednakże, dla uproszczenia, skrypty instalacyjne zazwyczaj uruchamiają wszystkie elementy warstwy sterowania na tej samej maszynie i nie uruchamiają kontenerów użytkownika na tej maszynie. Zobacz Tworzenie klastrów o wysokiej dostępności za pomocą kubeadm dla przykładowej konfiguracji warstwy sterowania, która działa na wielu maszynach.

kube-apiserver

Serwer API jest składnikiem warstwy sterowania Kubernetesa, który udostępnia API. Server API służy jako front-end warstwy sterowania Kubernetesa.

Podstawową implementacją serwera API Kubernetesa jest kube-apiserver. kube-apiserver został zaprojektowany w taki sposób, aby móc skalować się horyzontalnie — to oznacza, że zwiększa swoją wydajność poprzez dodawanie kolejnych instancji. Można uruchomić kilka instancji kube-apiserver i rozkładać między nimi ruch od klientów.

etcd

Magazyn typu klucz-wartość (key/value store), zapewniający spójność i wysoką dostępność, używany do przechowywania wszystkich danych o klastrze Kubernetesa.

Jeśli Twój klaster Kubernetesa używa etcd do przechowywania swoich danych, upewnij się, że masz opracowany plan tworzenia kopii zapasowych tych danych.

Szczegółowe informacje na temat etcd można znaleźć w oficjalnej dokumentacji.

kube-scheduler

Składnik warstwy sterowania, który śledzi tworzenie nowych podów i przypisuje im węzły, na których powinny zostać uruchomione.

Przy podejmowaniu decyzji o wyborze węzła brane pod uwagę są wymagania indywidualne i zbiorcze odnośnie zasobów, ograniczenia wynikające z polityk sprzętu i oprogramowania, wymagania affinity i anty-affinity, lokalizacja danych, zależności między zadaniami i wymagania czasowe.

kube-controller-manager

Składnik warstwy sterowania odpowiedzialny za uruchamianie kontrolerów.

Z poziomu podziału logicznego, każdy kontroler jest oddzielnym procesem, ale w celu zmniejszenia złożoności, wszystkie kontrolery są skompilowane do jednego programu binarnego i uruchamiane jako jeden proces.

Istnieje wiele różnych typów kontrolerów. Niektóre z nich to:

- Kontroler węzłów (ang. Node controller): Odpowiada za zauważanie i reagowanie, gdy węzły przestają działać.

- Kontroler zadania (ang. Job controller): Monitoruje obiekty zadania (Job), które reprezentują jednorazowe zadania, a następnie tworzy Pody, aby wykonały te zadania do końca.

- Kontroler EndpointSlice: Uzupełnia obiekty EndpointSlice (aby zapewnić połączenie między Services a Pods).

- Kontroler ServiceAccount: Tworzenie domyślnych obiektów ServiceAccount dla nowych przestrzeni nazw.

Powyższa lista nie jest wyczerpującą.

cloud-controller-manager

Element składowy warstwy sterowania Kubernetesa, który zarządza usługami realizowanymi po stronie chmur obliczeniowych. Cloud controller manager umożliwia połączenie Twojego klastra z API operatora usług chmurowych i rozdziela składniki operujące na platformie chmurowej od tych, które dotyczą wyłącznie samego klastra.Manager 'cloud-controller' uruchamia tylko kontrolery specyficzne dla dostawcy chmury. Jeśli uruchamiasz Kubernetesa w swojej siedzibie lub w środowisku do nauki na swoim komputerze osobistym, klaster nie posiada managera 'cloud-controller'.

Podobnie jak kube-controller-manager, cloud-controller-manager łączy kilka logicznie niezależnych pętli kontrolnych w jedną binarkę, którą uruchamiasz jako pojedynczy proces. Możesz go skalować horyzontalnie (uruchamiając więcej niż jedną kopię), aby poprawić wydajność lub pomóc w tolerowaniu awarii.

Następujące kontrolery mogą mieć zależności od dostawcy chmury:

- Kontroler węzłów (ang. Node controller): Do sprawdzania dostawcy chmury w celu ustalenia, czy węzeł został usunięty w chmurze po tym, jak przestaje odpowiadać.

- Kontroler tras (ang. Route controller): Do konfiguracji tras w podstawowej infrastrukturze chmurowej.

- Kontroler usługi (ang. Service controller): Do tworzenia, aktualizowania i usuwania load balancerów dostawcy chmury.

Komponenty węzła

Komponenty węzła działają na każdym węźle, utrzymując działające pody i zapewniając środowisko wykonawcze Kubernetesa.

kubelet

Agent, który działa na każdym węźle klastra. Odpowiada za uruchamianie kontenerów w ramach poda.